Extrait du rapport de recherche « Forges métiers dans le domaine de l’architecture, de l’ingénierie et de la construction : principes et prototypes » pp. 34-39

(…) le principe même d'Usine-IA est polysémique, voire ambigu, ou sujet à discussion. Le concept est sûrement amené à évoluer au gré des rapides évolutions qui caractérisent cette nouvelle phase technologique, et le terme sera peut-être sujet à réévaluation à l'avenir. Malgré ces nombreux questionnements concernant la pérennité, ou la validité des termes employés, nous choisissons de garder le terme d'Usine car il fait référence directement au principe sous-jacent d'« usine logicielle » qui correspond aux principes que nous cherchons à décrire. En informatique, on parle d' « usine logicielle » pour évoquer, comme nous le détaillons plus loin, des systèmes d'automatisation de création logicielle.

Nous commençons par donner quelques définitions de principes telles que nous les avons publiées sur le site CodeAtlas 1.

Les Usines-IA sont des systèmes de production logicielle de dernière génération fondés sur les mécanismes de l'IA générative. S'agissant d'un terme faisant référence à une technologie émergente, il n'est pas totalement univoque et prend aujourd'hui deux sens distincts :

Dans un sens général, le terme d'Usine-IA (1) renvoie généralement à des infrastructures de type « supercalculateur » permettant de concevoir et de fabriquer les modèles fondamentaux de dernières générations (LLM) comme c'est le cas avec le programme européen AI Factories, et GENCI en France.

Dans un sens « dérivé », le terme d'Usine-IA (2) renvoie plutôt à des « superstructures » de production logicielle faisant usage de modèles de fondation (LLM) ; c'est par exemple ce que décrit Wikipédia en anglais à l'entrée AI Factory.

Bien que ces deux types d'« Usines » soient corrélés, nous faisons ici référence aux Usines-IA « applicatives » (2), spécifiquement dans leur articulation avec le caractère disruptif du Vibecoding. Les métiers du développement informatique connaissent actuellement une vague d'innovation radicale avec l'avènement d'agents intelligents capables de produire des logiciels de façon « semi-autonome ». Même si le sujet soulève de nombreuses questions (de sécurité notamment) et suscite des débats enflammés, nombreuses sont aujourd'hui les entreprises qui annoncent des réductions d'effectifs en lien avec cette « révolution ».

Cette vague d'innovation va donc impacter tous les secteurs du numérique et représente autant de défis, et d'opportunités, pour le secteur culturel et le monde de l'architecture. Dans un environnement aujourd'hui dominé par des acteurs américains, il y a là un enjeu important pour le futur numérique de la construction, particulièrement dans le domaine stratégique de la construction hors-site.

C'est dans ce contexte de génération semi-automatique de logiciels (vibecoding) que les Usines-IA sont amenées à jouer le rôle de plateformes de développement des outils de conception de l'architecture de nouvelle génération. Pour bien comprendre le rôle et le fonctionnement de ces Usines d'un nouveau type, il est important de saisir comment elles s'articulent avec les Forges de développement.

Les Forges sont des plateformes de développement essentielles et centrales dans les processus de conception-fabrication-livraison des logiciels et infrastructures numériques. L'Usine-IA, entendue comme un pôle de fabrication d'application, est une extension des Forges sur lesquelles elle vient en quelque sorte se greffer, pour les étendre. On pourrait résumer cette relation ainsi : « Forges pour les humains, Usines pour les agents ».

Les Usines-IA et les modèles d'IA open-source sont donc amenés à bouleverser les méthodes de production logicielle comme cela a été discuté à l'occasion de la présentation « OpenR1 et le futur des Usines-IA » en avril 2025 pendant les rencontres « Alliance » de la DINUM.

C'est sur la base de ces éléments, qu'un prototype d'Usine-IA pour l'architecture a été réalisé lors d'un hackathon (AnythingButton) en avril 2025, récompensé par un prix (Most Impactful Hack) décerné par un jury composé de professionnels tels que : Zaha Hadid, Foster+Partner (Londres) et Thornton Tomasetti (New-York).

Au centre de ce tourbillon d'innovations déclenché par l'irruption de l'IA générative et des Grands Modèles de Langages (LLM) basés sur l'architecture « Transformer » 2, un élément en particulier semble être en train de redéfinir en profondeur la façon dont nous interagissons avec nos outils informatiques : les « agents ». La nature de ces « agents intelligents » ou plus généralement de l'IA « agentique » reste sujet de débat, notamment en ce qui concerne la distinction qui peut être faite entre une « simple » chaîne d'automatisation basée sur un LLM (workflows) et un « agent » à proprement parler. Sur ce terrain, un compromis semble trouvé sur le caractère « non-linéaire » d'un agent qui prend des « décisions » au sujet des tâches qui lui sont confiées.

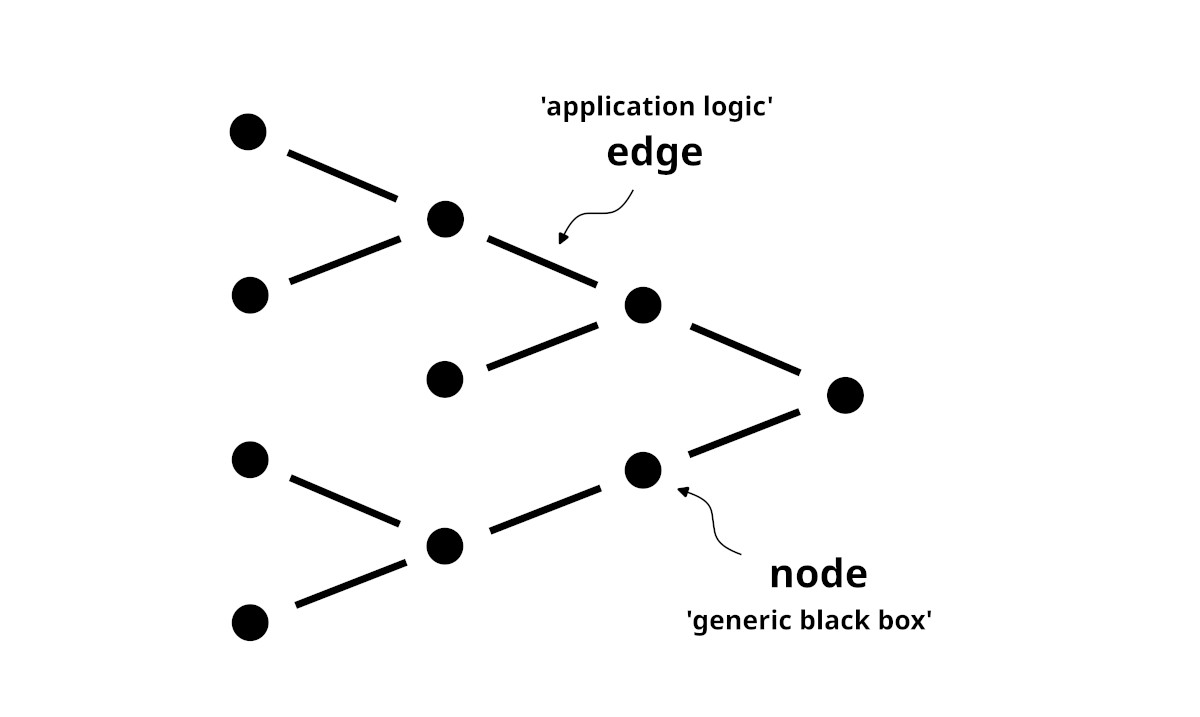

Dans ce contexte, le protocole MCP (Model Context Protocol) est en train d'unifier la question centrale des « appels d'outils » (tool calling) par des LLM, qu'ils soient réalisés par des agents ou par des workflows. Avec ce nouveau protocole, n'importe quelle application peut être « interfacée » pour être utilisable par un LLM. Au final, qu'il s'agisse d'agents ou de workflow, l'innovation portée par ce protocole réside dans la « mise en réseau » des applications qui deviennent autant d'outils à la disposition des IA. Les interfaces d'applications populaires telles que n8n à base de « programmation visuelle », rappellent directement les interfaces utilisées en conception générative et dans de nombreuses applications 3D contemporaines.

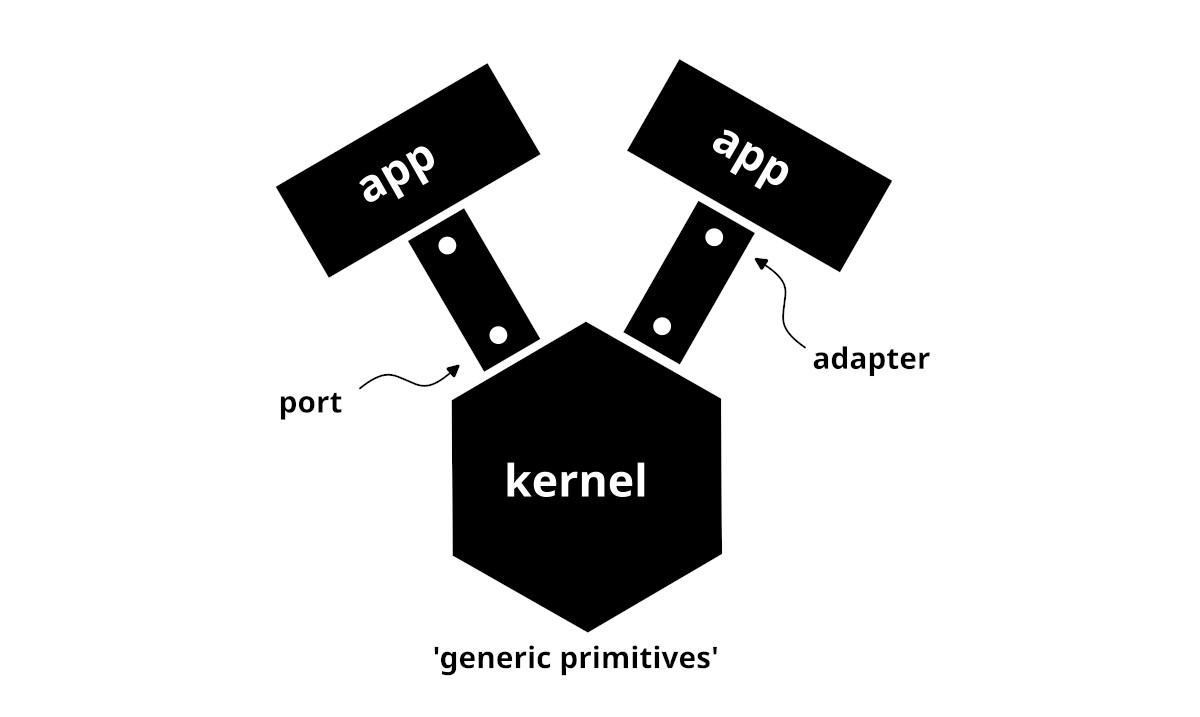

Nous avons décrit dans un papier de recherche intitulé « Modélisation par le flux » quels étaient les principes au centre de ce paradigme qui fonctionne, à la manière des API et des architectures de types « microservices », en connectant des points de sorties sur des points d'entrées pour former des flux de données (dataflow) à partir d'une collection d'applications ou de librairies logicielles accessibles depuis le réseau. Nous avons montré, lors d'une présentation de GitAec à Zurich en 2025, comment l'architecture « hexagonale » — de type ports and adapters — était un paradigme commun à des plateformes telles que Speckle, BHoM ou Compas.

Nous avons montré à la même occasion comment l'architecture d'une Forge, fonctionnait sur un schéma qui répondait aux attentes de la problématique de la modélisation par le flux. Les Forges fonctionnent comme des plateformes (hubs) où convergent et sont traités des flux de différentes natures. Plus généralement, dans le contexte de la modélisation générative, nous avons montré comment les principes même de l'intégration continue (CI/CD) apportaient une réponse intéressante pour gérér et orienter les flux génératifs, avec des données et des fonctions en amont stockés et versionnés sur une Forge, et des données et des modèles générés en aval. Nous avons souligné l'importance du « sens » d'écoulement de ce flux qui conditionne le rapport « générant => généré ».

Avec le protocole MCP (Model Context Protocol) 3 et l'IA « agentique », la mise en réseau des outils numériques semble s'inscrire dans une tendance qui, à bien des égards, n'est pas sans rappeler les débuts de l'Internet. Longtemps « confinée » dans les labos des universités et des grands groupes numériques, l'IA est restée jusqu'à présent affaire de spécialistes, réservé à un petit nombre. Mais depuis l'ouverture au grand public de ChatGPT en novembre 2022, tout semble indiquer que nous sommes entrés dans une nouvelle phase d'évolution rapide des technologies, et l'emballement actuel des marchés financiers fait penser à l'« euphorie » des années 2000 qui s'était soldée par l'éclatement de la « bulle Internet ».

S'agissant de trouver des points de comparaison avec l'émergence de l'Internet, on pourrait trouver des similarités dans deux domaines en particulier : l'« IA open-source » et l'« IA décentralisée ». En matière de disruption dans ce domaine, le 20 janvier 2025 est à marquer d'une pierre blanche avec la sortie du modèle DeepSeek R1 et ce « moment Spoutnik » en provenance de la Chine. Comme nous le documentons au fil de l'eau sur Codeberg 4, cette date marque l'« explosion » des modèles open-source d'IA, et le rôle central que joue la Chine dans cette affaire. À ce sujet, deux rapports publiés coup sur coup par la Maison Blanche et par Pékin en juillet 2025 confirment le rôle crucial que va jouer l'open-source dans cette bataille « hégémonique » de l'IA générative.

Dans ce contexte marqué par des tensions géopolitiques, qu'il s'agisse d'un embargo sur les puces de nouvelle génération du côté américain ou du contrôle de l'information dans le cas des LLM produits sous pavillon chinois, la question de la très forte « centralisation » de ces nouvelles technologies est posée. Dans un livre blanc intitulé « A Perspective on Decentralizing AI » récemment publié par le MIT, la question de la décentralisation des « infrastructures LLM » est posée, ouvrant peut-être, un nouveau chapitre dans l'histoire de Grands Modèles de Langage, avec des initiatives telles que celles de PrimeIntellect 5. Une initiative qui pourrait annoncer une nouvelle ère de l'IA dans laquelle open-source et protocoles décentralisés garantiraient que la technologie reste entre les mains des individus, au service de l'intérêt général.

Le « T » de l'acronyme GPT pour Generative Pretrained Transformer.↩︎

Voir https://modelcontextprotocol.io/docs/getting-started/intro↩︎